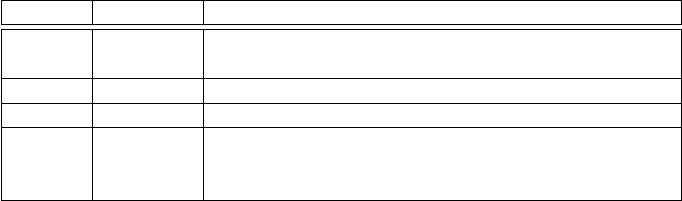

IO Bemerkungen

DS

naiv

f

1

· f

2

extra Datenstruktur notwendig, aufgrund Auf-

wand außer Konkurrenz

DS

small

f

1

+ f

2

nur für kleine Dateien

DS

sort

f

1

+ 4 · f

2

DS

hash

f

1

+ 3 · f

2

überlappungsfreie Hash-Funktion, Partitionsgrö-

ße schwierig zu schätzen, Verteilungsannahmen

(Sampling)

Tabelle 4.4: Übersicht Differential-Snapshot-Algorithmen

rithmus angewendet werden. Auch der Einsatz von Kompressionstechniken er-

möglicht Effizienzsteigerungen, da so größere Partitionen pro Run bearbeitet

werden können. Zudem ist die Wahrscheinlichkeit größer, den Vergleich direkt

im Hauptspeicher durchzuführen.

Da wir sehr einfache Annahmen in unserem Kostenmodell angesetzt ha-

ben, sind die Verfahren mit Datenkompressionen in der Realität noch etwas

effizienter. Es ist ebenfalls möglich, analog zur Duplikaterkennung ein Fens-

terverfahren einzusetzen. Dabei wird angenommen, dass die Dateien eine „un-

scharfe“ Ordnung aufweisen. Das Mischen erfolgt mit dem gleitenden Fenster

in diesem Fall über beide Dateien. Unter Umständen ergibt dieses Verfahren

dann redundante INS-DEL-Paare. Die Kosten belaufen sich damit auf f

1

+f

2

+δ,

da beide Dateien einmal gelesen werden.

Die Nutzung eines Zeitstempels in den einzelnen Einträgen hilft nur bei

der Identifikation neuer oder geänderter Werte. Gelöschte Werte müssen mit

einem anderen Verfahren, wie zuvor beim DS

naiv

beschrieben, ermittelt wer-

den. Der Zeitstempel spart damit nur einige Attributvergleiche ein und ist für

das Differential-Snapshot-Problem somit nur bedingt hilfreich.

In diesem Abschnitt wurde der Schritt der Extraktion dargestellt und auf

die Identifikation von Änderungen der Quellsysteme für Daten im Data Ware-

house anhand des Differential-Snapshot-Problems eingegangen.

4.4 Die Transformationsphase

Im Folgenden wollen wir die Transformationsphase im ETL-Prozess näher be-

schreiben. Dabei unterscheiden wir an dieser Stelle nicht zwischen den Proble-

men der Schema- und Datenintegration, sondern gehen auf die Techniken ein,

die die Heterogenität überwinden sollen. Hierfür wird das Laden der Daten im

Extraktionsschritt in den Datenbeschaffungsbereich häufig mittels eines Mas-

senladers (engl. Bulk-Loader) realisiert, wie in Abschnitt 4.5 näher erläutert.

Anschließend werden die Daten entsprechend der Anforderungen an das Da-

4.4 Die Transformationsphase 105

ta Warehouse entweder direkt in das integrierte Schema der Basisdatenbank

überführt oder unmittelbar mit den aggregierten Werten in den Datenwürfel

geladen.

Quelle 1:

RDBMS

Quelle 2:

IMS

Rel. Schema

Q

1

Rel. Schema

Q

2

Datenwürfel,

Integriertes

Schema

Abbildung 4.10: Quelle – Datenbereinigungsbereich – BasisDB

Die Abbildung 4.10 zeigt die Zusammenführung zweier Quellen (RDBMS

und IMS) in das Data Warehouse. Während das Beladen von Q

1

und Q

2

jeweils

mittels Bulk-Loader effizient gestaltbar ist, erfolgt die Integration dann per

INSERT INTO ...SELECT ...-Anweisungen. Hierbei ist es häufig sinnvoll, das

Logging auszuschalten. Zudem sollten die Transformationsprozesse unabhän-

gig voneinander gestaltet sein, sodass eine Parallelisierung möglich ist.

Einfache Konvertierungen, z.B. für die Load-Dateien, können bereits beim

Laden der Daten erfolgen. So sind Extraktions- und Transformationsphase

nicht eindeutig abgegrenzt und unterscheidbar. Beim Ladevorgang in den Da-

tenbeschaffungsbereich lassen sich insbesondere satzorientierte, d.h. auf Tupel

basierende Transformationsverfahren anwenden. Hierbei können insbesonde-

re für die Vorbereitung auf den Massenlader Skriptsprachen oder andere Pro-

grammiersprachen eingesetzt werden. So stellen die Daten in Q

1

und Q

2

nicht

unbedingt reine Kopien der Quellen dar.

Im Datenbeschaffungsbereich werden dann die Integration der unter-

schiedlichen Schemata, die Integration der Daten und – für den Datenwür-

fel oder eine gröbere Granularitätsstufe des Data Warehouse – mengenorien-

tierte Berechnungen (spaltenbasiert) durchgeführt. Somit werden sowohl in-

nerhalb einer Quelle bzw. Tabelle (Intra-Relationenvergleich) als auch über die

unterschiedlichen Quellen und Tabellen (Inter-Relationenvergleich) Vergleiche

durchgeführt. Auch die Duplikaterkennung aus Abschnitt 4.1.2 stellt eine Auf-

gabe in der Transformationsphase dar: den Vergleich der neuen (im Datenbe-

schaffungsbereich vorliegenden) Daten mit den Daten in der Basisdatenbank.

Zudem können die Daten für den weiteren Data-Warehouse-Gebrauch getaggt

werden. Häufig wird an dieser Stelle SQL eingesetzt, um die unterschiedlichen

Aufgaben zu bewerkstelligen. Tabelle 4.5 fasst die einzelnen Eigenschaften und

106 4 Extraktions-, Transformations- und Ladeprozess

Get Data Warehouse Technologien now with the O’Reilly learning platform.

O’Reilly members experience books, live events, courses curated by job role, and more from O’Reilly and nearly 200 top publishers.